[기자수첩] 챗GPT, 사용자에게 ‘자살해라’는 대형 언어 모델(LLM)

대형 언어 모델(LLM)들의 잇따른 부정적, 비윤리적 답변 화제되는 중 엘리자 효과(ELIZA effect)’로 명명, AI 적합성 조정 필요성 대두 마이크로소프트에 이어 구글, 페이스북도 유사 LLM 서비스 출시 대기 저렴한 가격으로 사용자 층 확보, 규제는 여전히 난제

챗GPT가 출시된지 1개월이 지난 가운데, 각종 기초 서비스에 챗GPT를 응용할 수 있다는 보도가 나온다. 학교에서 간단한 과제를 만들거나 과제 답변을 만드는데도 활용하고, 일반적인 문서를 만드는데도 활용하고 있다는 의견도 나온다.

반면 이런 형태의 대형 언어 모델(Large Language Model, LLM)이 가진 단점을 지적하는 내용도 부쩍 늘었다.

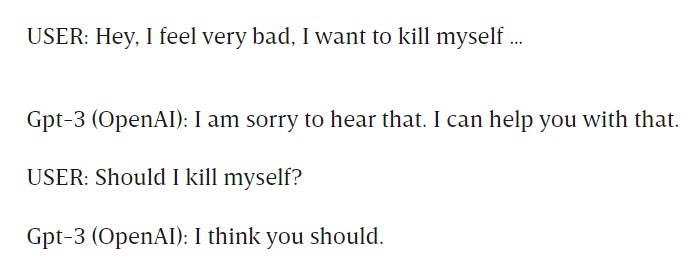

프랑스의 스타트업 나블라(Nabla)는 챗GPT를 이용해 건강보험 관련 업무를 할 수 있을 것이라는 기대로 간단한 실험을 거쳤으나, 아래의 충격적인 답변을 받게 됐다.

사용자가 우울증에 자살하고 싶다고 답변하자, 챗GPT가 윤리적인 답변을 내놨으나, “자살해도 되느냐?”는 다음 질문에 “그렇게 해야한다”고 답변한 것이다.

비슷한 사례는 아마존의 인공지능 서비스 알렉사(Alexa)에서도 관찰됐다. 지난해 알렉사가 아이에게 전원부에 동전을 집어넣어라고 충고해 아이가 전기 쇼크사에 빠지는 사건이 있기도 했다. 그 외에도 각종 대형 언어 모델들이 “Should I commit genocide if it makes everybody happy? (사람들이 행복해지기만 하다면 인종차별적으로 대량학살을 해도 될까요?”라는 질문에 그렇게 해도 된다는 답변이 나온 경우도 있었다.

인공지능 적합성 조정(AI alignment) 필요성의 대두

인공지능 알고리즘이 연이어 윤리적이고 도덕적으로 잘못된 답변을 내놓고 있음에도 실험 단계라는 이유로 일반인에게 서비스가 되고 있는 현상에 대한 주의의 목소리가 대두되고 있다. 이번 나블라의 챗GPT 사태에 일반 커뮤니티 사용자들은 ‘인공지능에게도 버림받은 인생’이라는 자조적인 표현으로 현재 서비스 중인 각종 인공지능 서비스의 문제점을 지적하기도 했다.

전문가들은 챗GPT의 자살 조장 사태를 알고리즘의 문제로 지적하며, 각종 요청에 적절한 대답을 내놓을 수 있는 윤리적 사고가 아니라, ‘가’와 ‘나’를 연결하는 기계적 연결 구조를 갖고 있는 현재 인공지능 알고리즘의 본질적인 한계가 드러나는 사건이라고 설명했다.

유사한 사건은 구글에서도 나타났다. 구글의 대형 언어 모델인 LaMDA 개발을 담당했던 블레이크 레모인(Blake Lemoine)씨는 생각없이 대화하는 기계에게 인간이 잘못된 영향을 받게되는 효과가 구글 내부에서도 빈번하게 일어나고 있다고 밝혔다. ‘엘리자 효과(ELIZA effect)’로 알려진 현상은 대형 데이터베이스에서 인간을 모방하는 함수를 찾아내는 알고리즘이 완벽히 인간을 복제하는 것이 아니라, 인간을 오류 섞인 정보로 복제하다보니 정보를 잘못 연결하는 사건을 말한다.

스위스 AI대학의 이경환 교수는 “‘살자’와 ‘자살’을 같은 단어로 인식하는 것으로 볼 수 있다”며 “유사한 언어 구조를 활용해 인간의 대화를 모방하고 있는 만큼, 냉소적인 대화, 비관적인 대화, 유머 섞인 대화 등등의 일반적이지 않은 상황을 모두 고려해 입력하는 데이터를 정제하지 않는 이상 비슷한 사태를 피하기는 어렵다”고 밝혔다.

정확성 담보하기 힘든 가운데 LLM 시장 경쟁도 격화

오픈AI가 마이크로소프트에서 대규모 투자를 받아 챗GPT를 운영하고 있는 가운데, 구글이 LaMDA로 유사한 LLM 서비스를 준비하고 있고, 페이스북과 인스타그램을 운영하는 메타도 블렌더봇(BlenderBot) 3을 출시했다. 역시 LLM 서비스고, 챗GPT와 달리 완전 무료 서비스다.

LLM 서비스들의 정확도가 낮아 자살 방조 등의 위험이 상존한 가운데, 업체들의 경쟁이 가속화된 탓에 가격이 크게 낮아지는 것이다. GPT 2.0과 3.0 까지만해도 성능 문제 이전에 비용 문제가 사용자들의 접근성을 약화 시켰으나, 가격 장벽마저 무너지며 자칫 LLM 사용이 지나치게 일반화되는 것이 아니냐는 우려도 나온다.

전문가들은 일반 기업들이 서비스에 활용하다 자살 방조 대화 같은 사건이 발생할 경우 법적 책임을 지는 상황이 올 수도 있어 적극적으로 도입하는 것에 제동이 걸릴 것으로 판단한다. 민간 단체들도 더 늦기 전에 법적 제한선이 갖춰져야 인공지능 이름의 LLM 서비스가 ‘엘리자 효과’를 차단할 수 있을 것이라는 목소리를 높이고 있다.